1. 発表者:

酒見 悠介(東京大学 生産技術研究所 民間等共同研究員/日本電気株式会社)

森野 佳生(研究当時:東京大学 生産技術研究所 特任助教/現在:九州大学 大学院総合理工学研究院 准教授)

Timothée Leleu(東京大学 生産技術研究所 特任准教授)

合原 一幸(東京大学 特別教授/国際高等研究所ニューロインテリジェンス国際研究機構(WPI-IRCN)副機構長)

2. 発表のポイント:

◆次世代人工知能として期待されているリザバーコンピューティングに関して、予測精度を損なわずにモデルサイズを削減する手法を開発した。

◆本手法を用いることにより、標準的な予測タスクで最大10分の1までモデルサイズ削減可能なことを示した。

◆モデルサイズの削減は、ハードウェア実装の低消費電力化に繋がり、今後の人工知能の重要な応用であるエッジAIを可能にする。

3.発表概要:

東京大学 生産技術研究所の酒見 悠介 民間等共同研究員、Timothée Leleu 特任准教授、森野 佳生 特任助教(研究当時、現:九州大学 准教授)と合原 一幸 特別教授(東京大学 ニューロインテリジェンス国際研究機構 副機構長)らの研究チームは、次世代人工知能として期待されているリザバーコンピューティングにおいて、予測精度を損なわずに、モデルサイズを最大10分の1に削減する手法を開発した(図1)。

なお、本成果は本論文の投稿に先立ち、東京大学と日本電気株式会社(NEC)から特許申請がなされている(発明の名称:機械学習装置、情報処理方法およびプログラム 出願番号:特願2019-206438)。本研究の一部は、NECと東京大学との社会連携研究部門『ブレインモルフィックAIプロジェクト』の助成を受けたものである。

4.発表内容:

■ 背 景

近年の人工知能技術の発展により、実社会の様々な領域で人工知能が活用され始めている。さらに最近では、ヘルスケアや医療現場、製造業などの領域において、センサーやウェアラブルデバイスからのデータをリアルタイムに監視および分析する応用への期待が高まっている。この新たな人工知能活用の場はエッジAI(注1)と呼ばれている。これを実現するための鍵は、少ない電力でも動作可能な新しい人工知能技術の開発である。リザバーコンピューティングは次世代人工知能の一種であり、ハードウェア実装した場合、現在の代表的な人工知能であるディープラーニングに比べて、少ない電力かつ短い学習時間で動作すると期待されている。リザバーコンピューティングを実際に少ない電力で動作させるには、そのモデルサイズ(注2)を小さく抑える必要があるが、その場合、予測精度が損なわれてしまう問題が知られている。すなわち、リザバーコンピューティングでエッジAIを実現するには、より小さいモデルサイズで、より高い予測精度を出す工夫が求められる。

■ 内 容

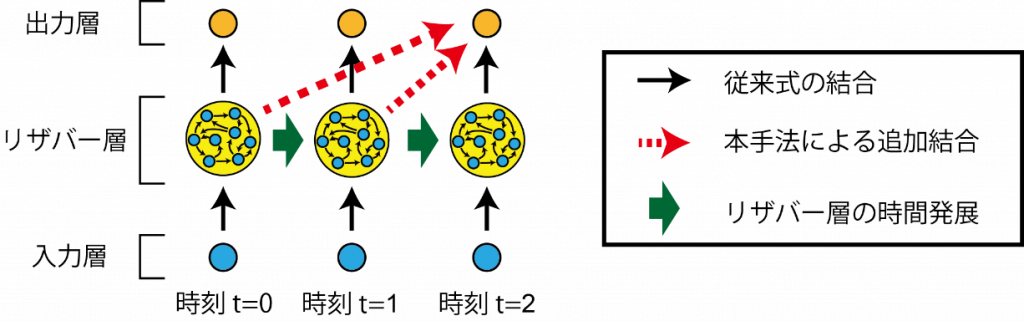

リザバーコンピューティングは入力層、リザバー層、出力層で構成されている。本手法の特徴は、リザバー層から出力層への結合構造の改良にある(図1)。通常のリザバーコンピューティングでは、時刻tのリザバー層から、時刻tの出力層への結合のみを考慮する。本手法では、上記の結合に加えて、複数の異なる過去の時刻t’のリザバー層から、時刻tの出力層への結合を追加する。これにより、リザバー層のモデルサイズは、追加した結合の数に応じて削減することが可能になる。

■ 効 果

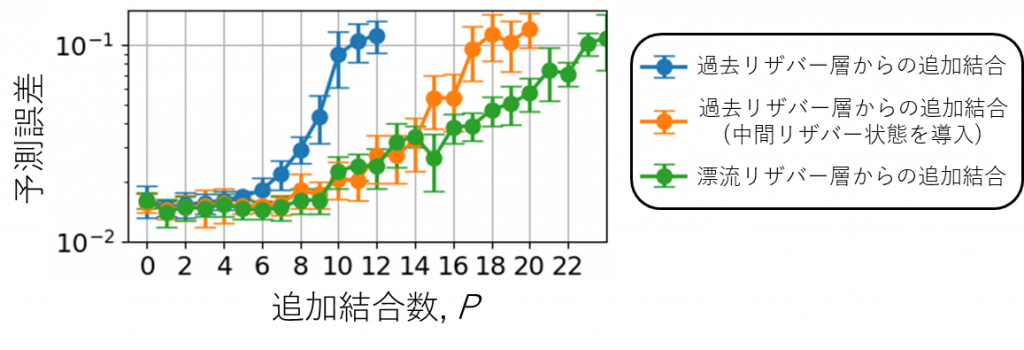

本手法を標準的な予測タスクであるNARMAタスク(注3)で検証したところ、予測精度を損なわずモデルサイズを最大で10分の1に削減できることがわかった(図2)。さらに、論文中では数理的な解析も行うことで、本手法の有効性の数理的な裏付けを与えた。

この手法はハードウェア実装に適している。それは、複数の異なる時刻のリザバー層の状態は直接メモリに保存する必要はなく、より低次元の出力層での形で保存できるため、メモリ効率は極めて高い。さらに、この手法はリザバー層の構造に依存しないため、既存の様々な形態のリザバー層に適応可能である。

本手法はリザバーコンピューティングの低消費電力化を実現する汎用的なものであるため、リザバーコンピューティングをエッジAIなどに応用する際の重要な基盤技術の一つとなると考えている。

5.発表雑誌:

雑誌名:Scientific Reports

論文タイトル:Model-Size Reduction for Reservoir Computing by Concatenating Internal States Through Time

著者:Yusuke Sakemi, Kai Morino, Timothée Leleu, Kazuyuki Aihara

DOI番号:10.1038/s41598-020-78725-0

6.問い合わせ先:

東京大学 生産技術研究所 民間等共同研究員/日本電気株式会社

酒見 悠介(さけみ ゆうすけ)

九州大学 大学院総合理工学研究院 非線形物性学研究室

准教授 森野 佳生 (もりの かい)

東京大学 生産技術研究所

特任准教授 Timothée Leleu (ティモシー ルル)

東京大学 特別教授・名誉教授

東京大学国際高等研究所ニューロインテリジェンス国際研究機構(WPI-IRCN)

副機構長・主任研究者 合原 一幸(あいはら かずゆき)

7.用語解説:

注1)エッジAI

現在の人工知能は、一般的に、巨大なデータセンターの中で動作させる。エッジAIでは、ウェアラブルデバイスやモバイル端末など、電力上の制限が大きい環境下で動作をする。エッジAIの利点は、通信コストの低減、リアルタイム性の向上、データのプライバシーの向上などである。

注2)モデルサイズ

リザバーコンピューティングのリザバー層の大きさのことであり、通常、リザバー層を構成しているニューロンの数を示す。

注3)NARMA

NARMAタスクは非線形自己回帰移動平均モデルによって生成される複雑な時系列を予測するタスクであり、リザバーコンピューティングの性能評価によく用いられる。

8.添付資料:

図1 開発したモデルサイズ削減手法の一つ。異なる時刻のリザバー層から予測したい時刻の出力層への結合を追加する。これにより、リザバー層のサイズを変えずに、実効的なモデルサイズを増大させることができる。

図2 NARMAタスクにおける予測精度。リザバー層から出力層への追加結合数(P)を増やしたとき、同時に、モデルサイズをP+1分の1にしている。ある程度の追加結合数までは予測誤差が悪くならないことがわかる。三つの線はそれぞれ異なる形態の提案手法の結果を示している。青線の過去レザバー層からの追加結合は図1の形態に相当。中間リザバー状態を導入する場合は、リザバー層は各時刻で入力を二回取り込んで時間発展する。漂流レザバー層とは、各時刻におけるリザバー層が入力を受けずに時間発展した状態のことを示す。